La chronologie de Sylvain Maresca nous rappelle que c’est en 1999, avec la mise sur le marché du Nikon D1 qu’un grand nombre de photographes professionnels ont acquis leur premier appareil numérique. Les photos générées par cet appareil doté d’un capteur de 3 millions de pixels ont pendant quelques mois permis de réaliser des pages A4 dans de nombreux magazines pour la plus grande joie des photographes et de leurs clients.

12 ans plus tard, Nikon commercialise un appareil doté de 36 millions de pixels (sur un capteur deux fois plus grand), le Nikon D800.

Les éléments qui font qu’un appareil vous permettra de produire des images correspondants à vos attentes sont très nombreux, différents selon le type d’image que l’on souhaite réaliser (et son degré d’expertise), et ne relèvent pas de la seule qualité réelle ou supposée de son capteur. Mais en ce qui concerne la dimension qualitative des images, le nombre de pixels est devenu, pour des raisons marketing, le principal argument des fabricants. C’est une donnée numérique beaucoup plus facile à appréhender pour le consommateur que des critères tels que la dynamique, le gamut ou même la sensibilité pour établir une hiérarchie dans l’offre.

Pour des raisons liées au marketing, les fabricants se sont donc livrés à une course aux pixels qui ne se justifiait pas toujours en termes de qualité d’image car à technologie égale, au-delà d’un certain point, on ne gagne rien à avoir plus de pixels pour une même surface. On peut sur ce point lire mon article sur les Nikon 1.

En 1999, lorsque le Nikon D1 que j’ai évoqué précédemment a été introduit sur le marché, les techniciens voyaient alors dans un capteur Full-Frame (24×36 cm) de 8 millions de pixels, la frontière indépassable, le moment où la réduction de la dimension des photo-sites, nécessairement proportionnelle à leur nombre sur une surface donnée, présenterait plus d’inconvénients qu’elle n’apporterait de progrès significatif. Mais depuis la technologie a évolué avec en particulier l’utilisation de micro-lentilles qui vont focaliser la lumière sur les photo-sites et ont permis d’en réduire considérablement la surface tout en augmentant leur rendement. Cette supposée frontière a été dépassée depuis longtemps et à ma connaissance plus personne ne se hasarde à émettre des prédictions de ce type.

Dans cette course aux pixels, le D800 n’est pas juste un « coup » marketing comparable à ceux que l’on peut observer sur le marché des compacts. Cette progression du nombre de pixels ne s’est pas faite au détriment des autres éléments qui font la qualité d’une image numérique. Nikon a réussi à inscrire 36 millions de pixels sur un capteur 24×36 qui offre des performances comparables ou supérieures en termes de bruit, dynamique et gamut à son prédécesseur dans la gamme dite « experte », le Nikon D700 (annoncé par Nikon en juillet 2008) qui ne comptait « que » 12 millions de pixels. Le D800 est devenu une nouvelle référence technologique.

L’exploit technologique est remarquable, mais la multiplication par 3 du nombre de pixels n’est pas sans conséquences sur le traitement de l’image et les finances du photographe.

Plus de pixels, cela signifie également plus d’informations à traiter et à stocker que ce soit dans son appareil ou sur son ordinateur.

Les photos doivent être traitées par l’appareil, puis enregistrées sur une carte mémoire. Toutes ces opérations qui sont plus longues que le millième de seconde de la prise de vue sont effectuées dans une mémoire interne. Lorsque cette mémoire est pleine, la rafale s’interrompt le temps de libérer de l’espace. Plus les fichiers seront lourds, et plus vite cette mémoire sera saturée. Pour les photographes qui travaillent en rafales, le nombre d’images par seconde sera moins important ainsi que le nombre d’images qu’ils pourront réaliser en continu.

Il faut acheter des cartes mémoires de grande capacité, très performantes en matière de vitesse d’enregistrement et de lecture, et donc plus chères. Il faudra peut-être renouveler au moins en partie son parc d’objectifs pour que ceux-ci soient capables de transmettre les détails les plus fins que le capteur est capable d’enregistrer. (Je reviens un peu plus loin sur ce dernier point.) Et en général, plus un objectif est performant, et plus il est cher.

L’affichage et le traitement des images dans l’ordinateur seront plus lents. Il faudra s’accoutumer à un post-traitement plus lent ou renouveler son ordinateur. Il faudra acquérir rapidement de nouveaux disques durs externes pour archiver ses images

La stratégie commerciale de Nikon va d’ailleurs dans le sens de cette interrogation dans la mesure où deux appareils ont été annoncés quasi simultanément: le Nikon D800 destiné au marché « expert », à un prix TTC d’environ 2800 euros et le Nikon D4, destiné au marché « professionnel », doté de 16 millions de pixels vendu au prix de 5800 euros (TTC). Il me semble que c’est la première fois que Nikon sort simultanément son appareil amiral et un boîtier expert et que c’est ce dernier qui compte le plus de pixels.

On ne peut réduire la comparaison entre ces deux boîtiers à une différence de pixels, mais si Nikon pense pouvoir vendre deux fois plus cher, un boîtier qui compte deux fois moins de pixels, c’est donc bien qu’il y a lieu de s’interroger sur l’utilité de cette progression.

Est-ce que l’on pourra différencier une photo réalisée avec 12 millions de pixels d’un photo réalisée avec 36 millions de pixels? Est-ce que l’on va les retrouver (pour le meilleur comme pour le pire) dans sa photographie, ou n’est-ce qu’une prouesse technologique un peu vaine ?

Je n’ai considéré cette notion « d’utilité » que dans sa dimension technique à l’exclusion de toute considération esthétique, car il n’y a pas de liens directs entre le nombre de pixels et la prosécogénie d’une image. Certes, comme nous le verrons plus loin, la multiplication des pixels facilite la réalisation de tirages de très grands formats, et les grands formats sont très en vogue actuellement dans les expositions, mais je suppose que leurs auteurs seraient très mécontents si on leur disait que ce qui distinguait leurs images du tout venant ce ne serait pas leurs qualités intrinsèques, mais la taille de leurs tirages. Et à l’inverse le succès populaire d’applications telles qu’Instagram ou Hipstamatic nous montrent qu’une image peut séduire avec une poignée de pixels.

Le pixel, c’est l’unité de base de l’image. Un point qui est le plus petit élément d’information que le fichier numérique de l’appareil photo a enregistré et que l’écran d’ordinateur sera capable de reproduire. Ces points étant minuscules, l’œil va les confondre et nous donner l’illusion de lignes, de formes et de tons continus. Plus de pixels c’est donc, en principe, plus d’informations, plus de détails dans l’image.

Mais sur le terrain, plus de pixels ne signifie pas nécessairement que le capteur sera capable d’enregistrer plus de détails. L’objectif projette sur le capteur une image analogique qui va être convertie en un signal électrique puis numérisée et traitée pour donner une image numérique. Si l’image projetée par l’objectif sur le capteur est floue, le capteur quelque soit sa résolution, ne pourra pas discriminer les détails les plus fins. Et pour être tout à fait exhaustif, il faut même considérer le sujet. Les capteurs de 12 millions de pixels mettant déjà en évidence des détails très fins, il faut que dans le sujet de la représentation, il y ait des détails suffisamment fins pour que les 36 millions de pixels aient quelque chose à discriminer. Un paysage, plutôt qu’un portrait par exemple.

La contrainte est double.

Avant la prise de vue, parce qu’il va falloir posséder des objectifs d’une qualité exceptionnelle. Il faut que l’optique projette sur le capteur une image dont le définition soit au moins égale à sa résolution. Cela élimine beaucoup d’optiques disponibles sur le marché et supposera peut-être un renouvellement partiel de son matériel.

Pendant la prise de vue, parce qu’il faudra que le sujet et l’opérateur soient immobiles ou que la vitesse de prise de vue soit suffisamment rapide pour que leurs déplacements ne soient pas enregistrés par l’appareil. Le choix du diaphragme sera également très important, parce que même une optique exceptionnelle ne le sera pas nécessairement à toutes les ouvertures.

Si l’on ne se plie pas à ces contraintes les photos ne seront pas moins bonnes que celles que l’on aurait réalisées dans les mêmes conditions avec les 12 millions de pixels du Nikon D700, mais pas meilleures non plus. Ou alors ce sera pour des raisons qui ne tiennent pas au nombre de pixels, mais à la dynamique ou au gamut du capteur.

Enfin, l’image numérique doit être reproduite pour être visualisée, que ce soit en l’affichant sur un écran ou en l’imprimant sur du papier.

L’impression:

Lorsque l’on imprime une image, à chaque pixel on fait correspondre une goutte d’encre. Plus ces gouttes seront rapprochées et plus l’image imprimée semblera nette. L’unité qui sert à exprimer cette densité c’est le DPI (Dots Per Inch) qui décrit le nombre de pixels utilisé pour chaque pouce. Mais cette impression de netteté est également fonction du procédé d’impression utilisé et des limites de la vision humaine. La norme pour les livres d’art et l’impression des revues sur papier glacé est de 300 dpi, parce que si l’on examine ces épreuves à 25 cm de distance, l’œil ne verra plus de différence si l’on augmente la densité des points d’encre. Si l’on imprime des affiches en grand format, l’observateur va se reculer et de ce fait la densité pourra être beaucoup moins importante. Si l’on imprime l’image sur un quotidien on sera généralement plutôt à 150 dpi parce que le papier de mauvaise qualité boit l’encre qui va se diffuser autour de chaque point et une densité plus importante créerait des pâtés. Avec la technologie actuelle, les imprimantes photos ne discriminent pas plus de détail au-delà de 240 dpi.

Si la photo compte plus de pixels que ce qui est nécessaire à son impression, le logiciel va redimensionner le fichier pour réduire le nombre de pixels. La qualité d’impression sera comparable à celle que l’on aurait obtenu avec une image qui aurait été produite par un appareil disposant d’un capteur moins bien doté en pixels. Si la photo ne compte pas assez de pixels vis à vis du format et de la résolution d’impression, le logiciel va redimensionner l’image en multipliant les pixels existants pour produire une image satisfaisante pour l’œil. Les logiciels font des prouesses, mais il ne pourront pas inventer les pixels manquants et créer les détails qui étaient absents du fichier original.

J’ai ouvert l’image précédente avec Adobe Camera Raw comme si le fichier ne comptait que 12 millions de pixels. Puis j’ai gonflé mon image par interpolation logicielle à 36 millions de pixels pour mettre en évidence sur le crop la perte de définition dans les détails.

On voit donc que le principal intérêt des 36 millions de pixels est lié à la possibilité de réaliser des tirages grands formats de qualité supérieure à ceux que l’on pouvait réaliser avec la génération précédente. Je n’ai encore réalisé que peu de tests, mais il semble y avoir un consensus dans les revues spécialisées autour du

format A2 ( 420 X 594 mm ) lorsque l’on utilise une imprimante photo de qualité avec un papier permettant de reproduire des détails très fin. Il serait impossible de différencier une même prise de vue réalisée avec les 12 millions de pixels d’un D700 de celle qui aurait été réalisée avec les 36 millions de pixels d’un D800, si le format est plus petit que le A2. Et même là, cela supposerait que l’on mette côte à côte les deux tirages et que l’on se colle le nez dessus, voir que l’on utilise une loupe (ce qui n’est pas nécessairement la meilleur façon d’apprécier une image). Personnellement, sur la base des quelques tests que j’ai réalisés, j’aurais même tendance à penser qu’il faut passer au minimum au A1 pour que la différence soit réellement significative.

Mais c’est une notion qui reste très subjective et qui suppose que l’on place côte à côte deux tirages d’un même sujet, cadré de la même façon, et réalisé avec des capteurs différents. Si la prosécogénie de l’image est forte, le photographe aura facilement tendance à attribuer à la résolution de son capteur ce qui relève en réalité de la qualité esthétique de sa photo. Je viens de réaliser une exposition à partir de photos réalisées en 2004 avec un Nikon D70 de 6 millions de pixels. Elles étaient imprimées en 50x75cm, alors que théoriquement, pour avoir le maximum de qualité je n’aurais pas du dépasser le format 21×29,7 cm. Mes tirages étaient très beau. 🙂 Alors c’est certain que si je réalisais aujourd’hui ces prises de vue avec un Nikon D800, j’aurais un autre rendu, mais en l’absence de comparaison mes photos ont leur légitimité et aucun visiteur n’a eu le sentiment que la définition était insuffisante.

On parle donc d’utilisations exceptionnelles. Si aujourd’hui la plupart des imprimeurs refuseraient d’imprimer en A4 une photo réalisée avec les 3 millions de pixels du capteur du Nikon D1 que j’ai évoqué au début de ce billet, 12 millions de pixels sont amplement suffisants pour la plupart des photographes professionnels ou experts. Dans ma pratique professionnelle, je n’ai eu que deux fois des commandes pour lesquelles 12 millions de pixels étaient insuffisants.

Par contre tous les utilisateurs sont susceptibles de bénéficier de la possibilité offerte par ces 36 millions de pixels pour recadrer, même violemment, leurs images avant l’impression.

Le recadrage en photo est un sujet presque idéologique. On peut comme Henri Cartier Bresson faire du cadre de son appareil une vertu, mais on peut aussi souhaiter se libérer des proportions que l’outil nous impose. Plus on recadre, et plus on diminue le nombre de pixels de l’image. Jusqu’à présent, les capteurs étaient un peu juste en pixels pour envisager avec une totale liberté de se libérer du cadre de la prise de vue si l’on souhaitait pouvoir imprimer au mieux ses images.

Le numérique a introduit, me semble-t-il, une plus grande distance que l’argentique entre le photographe et le format lié à l’outil qui lui a permis de capturer l’image. Visualiser une image sur un écran modifie profondément le rapport au cadre. Agrandir une image sur son écran, c’est une expérience sensible très différente de celle qui consistait à regarder au compte-fil un négatif, un contact ou un film positif. On affiche la photographie sur un écran dont le format n’est pas homothétique de celui de la prise de vue. On zoom dans l’image pour optimiser son piqué, réduire un éventuel bruit numérique ou procéder à une retouche (qui sera d’autant plus imperceptible que le fichier sera redimensionné à l’impression par une réduction du nombre de pixels). C’est particulièrement vrai si l’on considère la façon dont on travaillait en argentique 24×36. Généralement, les photographes ne tiraient pas eux-mêmes leurs photos. Ils ne pouvaient pas les recadrer sous l’agrandisseur. Ils ne pouvaient que donner des indications grossières sur le contact. Avec le numérique, on va pouvoir les recadrer avec la même facilité que si l’on travaillait sur un agrandisseur. Pour un photographe de commande, le cadre de la prise de vue n’est souvent qu’une contrainte liée à l’outil qu’il a utilisé. Les photos sont réalisées pour s’insérer dans une mise en page préexistante et seront nécessairement recadrées. Ce recadrage est d’ailleurs le plus souvent pris en compte dès la prise de vue.

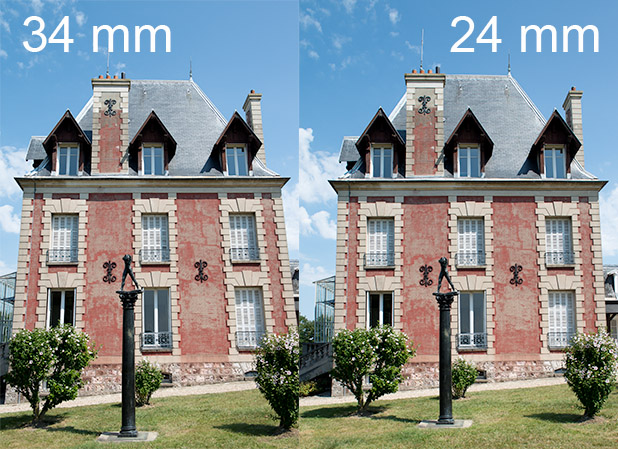

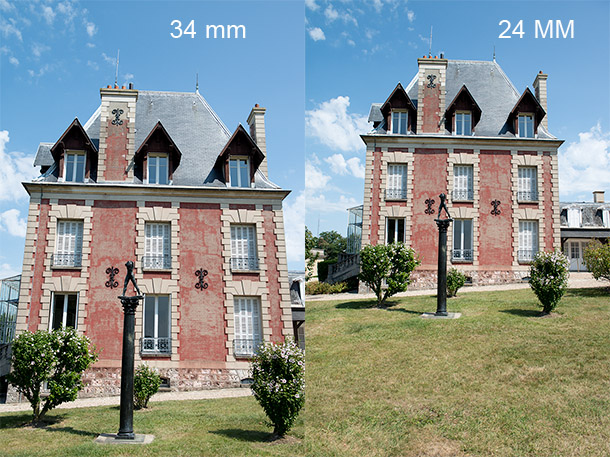

On peut également envisager le recadrage pour des raisons qui tiennent à la nature même de la représentation photographique. Sur des photographies d’architecture, l’inclinaison de l’appareil par rapport à la verticale va déformer les façades. La solution consiste à se reculer et à utiliser une focale plus longue pour conserver le même cadrage en modifiant le point de vue. Mais encore faut-il disposer de recul. Lorsque ce n’est pas le cas, l’utilisation d’une focale plus courte depuis le même emplacement permettra de redresser significativement l’appareil, et donc les fuyantes, mais supposera que l’on coupe dans l’image pour éliminer ce que l’on ne souhaitait pas représenter à l’origine.

Après avoir redressé les deux prises de vue et recadré la prise de vue réalisée avec le 24 mm. La déformation est plus discrète parce que l’appareil est moins incliné

L’affichage à l’écran:

Lorsque j’ouvre dans Photoshop une image du D800 sur mon écran de 1600×1200 pixels au rapport 1/1 (un pixel écran correspond à un pixel de mon image), je n’en visualise que 20% simultanément. Je peux la déplacer dans l’espace de l’écran pour la découvrir par petits, bouts, mais ça me fait un peu le même effet que si je regardais un tirage à la loupe. C’est dans sa globalité que j’apprécie mon image. Pour moi, l’affichage à l’écran d’une photo n’est qu’une étape dans le processus qui va me permettre de la finaliser. L’image n’existe réellement que lorsqu’elle est imprimée. Tant qu’elle n’est présente que sur mon disque dur, elle reste virtuelle.

Certes j’utilise mes photographies pour illustrer mon blog, mais pour ce faire je les redimensionne à leur format d’utilisation. Disons que l’écran est alors un papier d’un genre un peu particulier qui suppose un traitement particulier, et que si c’était la seule destination de mes images, un capteur de 3 mégapixels suffirait largement à mon bonheur.

Mais le numérique a transformé la façon dont de nombreux utilisateurs « consomment » une image et il existe une importante population de photographes qui ne réalisent que peu ou pas de tirages et qui apprécient la possibilité de pouvoir zoomer dans leurs images. Pour ces photographes, l’écran est devenu la façon naturelle d’apprécier une image. J’ai été très surpris de l’accueil enthousiaste réservé au Nikon D800 par des photographes qui ne réalisent jamais ou presque de tirages, mais pour qui 36 millions de pixels font du Nikon D800 un objet de désir auquel ils ne sauraient résister.

C’est pour l’instant un plaisir essentiellement solitaire, mais la démarche d’un photographe tel que celle de Jean François Rauzier me semble révélatrice d’un nouveau genre photographique qui tend à se dessiner entre Internet et cette possibilité de zoomer dans une image. Dans un tout autre registre, mais fonctionnant sur le même principe du zoom dans l’image, il me semble difficile de ne pas être fasciné par cette image du Royal Wedding. J’y vois la version démocratique du « Sacre de l’empereur Napoléon et couronnement de l’impératrice Joséphine » par David.

Conclusion:

Si je reprends la question que j’ai posée un peu brutalement au début de ce billet, l’utilité d’un appareil susceptible de délivrer des images d’une qualité technique supérieure à ce que nos sens sont susceptibles de percevoir ne devrait pas s’imposer.

Pourtant, je l’ai commandé avant même de l’avoir testé (contrairement à mes habitudes) et le succès commercial de cet appareil semble évident. J’ai du patienter 3 mois avant de pouvoir disposer de l’objet de ma convoitise, et pour l’instant j’en suis satisfait.

Bien entendu je peux justifier cet achat par toutes sortes d’arguments fonctionnels. Pour mon travail de commande, il est probable que ces 36 millions de pixels vont devenir rapidement la nouvelle norme, même si le plus souvent cela correspondra plus à l’idée que s’en feront les clients qu’à un réel besoin. Pour mon travail personnel, je dispose d’une imprimante en 60 cm de large et j’aime les grands formats. Avoir la possibilité de recadrer largement dans mon image m’apporte un vrai confort. Son principal défaut pour un usage professionnel, la modestie de ses rafales, n’en est pas un pour moi, car je ne suis pas un photographe sportif et mon tempérament me porterait plutôt à la contemplation.

Mais la raison principale, la vraie raison est toute autre. Le Nikon D800 est le paradigme de l’appareil destiné aux photographes qui continuent à privilégier l’instant de la prise de vue par opposition à ceux qui sont en train de révolutionner les usages sociaux de la photographie en réalisant « les images qui font la conversation ». 🙂

Superbe article qui décrit vraiment en profondeur les problématiques d’un capteur aussi fourni en pixels.

Je n’ai pas vraiment découvert quelque chose à proprement parler mais j’ai vraiment approfondi tout un tas de notions ou de morceaux d’informations glanées au grés de mes pérégrinations sur le web.

Merci Benjamin pour ce commentaire publié bien tardivement et je m’en excuse.

bonjour,

j’ai bien aimé votre article, je me pause une question ;

choir entre la taille de l image L ou M influencera la qualité de l’image pour un agrandissement A3 ou A4

Merci

Philippe NIVELEAU

Je ne suis pas certain de comprendre votre question.

12 millions de pixels, c’est largement suffisant pour réaliser un A3 ou un A4 et si vous intervenez peu au post-traitement de l’image, on ne devrait pas voir de différence de qualité, si c’est votre question.

A l’usage, (cet article a plus de deux ans), les 36 millions de pixels apportent aussi un plus grand confort au post-traitement. A la fois parce qu’il n’y a pas que le nombre de pixels mais également la dynamique qui a progressé avec ce capteur vis à vis de la précédente génération, mais également parce que si l’on fait des traitements localisés dans le logiciel qui permet d’ouvrir les raw, les transitions seront plus subtiles à format d’impression égal.